今早(北京时间3月19日),大约22000人齐聚美国加州圣何塞,参加由英伟达主办的盛会——GTC 2024 大会。此次盛会为期4天,作为公认的“AI风向标”,会议期间将提供超过900场会议,从机器人、汽车,到医疗、量子计算等各个领域,展示最新的人工智能创新。

鉴于过去一年多时间里AI带来的生产力变革,以及英伟达等一众概念股的表现,英伟达创始人黄仁勋的主题演讲《见证AI的变革时刻》,已经变成全球科技圈、资本界翘首以待的热门事件。

其实何止英伟达,还有不少企业也乘AI风而起,迎来自己的变革时代。比如挖矿起家的CoreWeave,几度面临财务危机,险些倒闭之时,在生成式AI突然爆火后命运齿轮开始转动,营收两年翻70倍,并以囤积的英伟达H100 GPU芯片为抵押,从黑石、Coatue等顶级机构获得了23亿美元的债务融资,估值飙至80亿美金(约合人民币575亿元)。

这一次GTC黄仁勋的演讲,主要包括4点:

2.软件服务方面,发布了集成AI开发软件微服务系统NIM;

3.发布定制模型开发软件Nemo,以及AI工厂;

4.发布数字孪生(Digital Twin)产品Omniverse Cloud以及机器人平台Isaac。

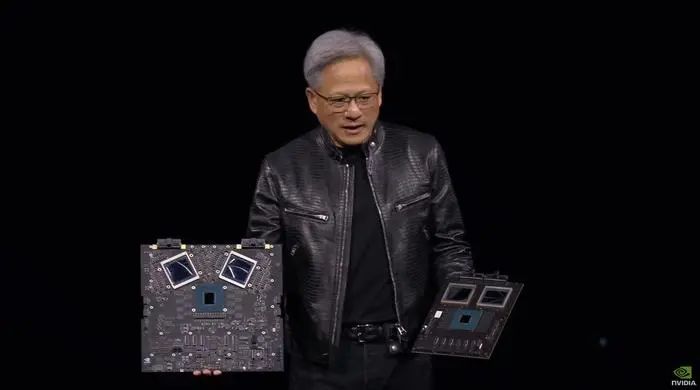

黄仁勋在GTC宣布推出新一代AI芯片架构BlackwellGPU,第一款Blackwell芯片名为GB200,将于今年晚些时候上市。Blackwell以美国国家科学院首位黑人学者DavidBlackwell的名字命名(上一代产品Hopper架构则是致敬格蕾丝·霍珀)。

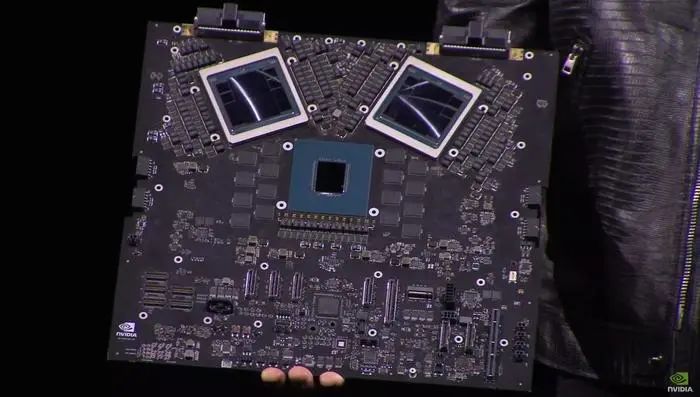

据了解,基于Blackwell的GB200拥有2080亿个晶体管,采用台积电4NP工艺节点,提供高达20 petaflops FP4的算力,是上一代Hopper架构H100的两倍多,H100晶体管数量为800亿。

英伟达表示,基于Blackwell的处理器,如GB200,为人工智能公司提供了巨大的性能升级,其AI性能为每秒20千万亿次浮点运算,而H100为每秒4000万亿次浮点运算,直接实现了5倍性能提升。

举个例子,如果用来训练类似于GPT-MoE-1.8T(猜测为GPT-4)模型,大概需要8000块Hooper架构GPU(H100),训练90天,消耗掉15 兆瓦的电力。

而使用GB200 NVL72系统,需要2000个GPU(每个GPU有两个Blackwell,所以实际上是4000个基础计算架构),同样90天,但是耗电量仅为 4 兆瓦,能耗只有使用目前Hooper架构系统的四分之一。

虽然Blackwell架构之前传出的信息已经比较充分了,但是“GB200 NVL72”这种连接方式还是略超预期的。

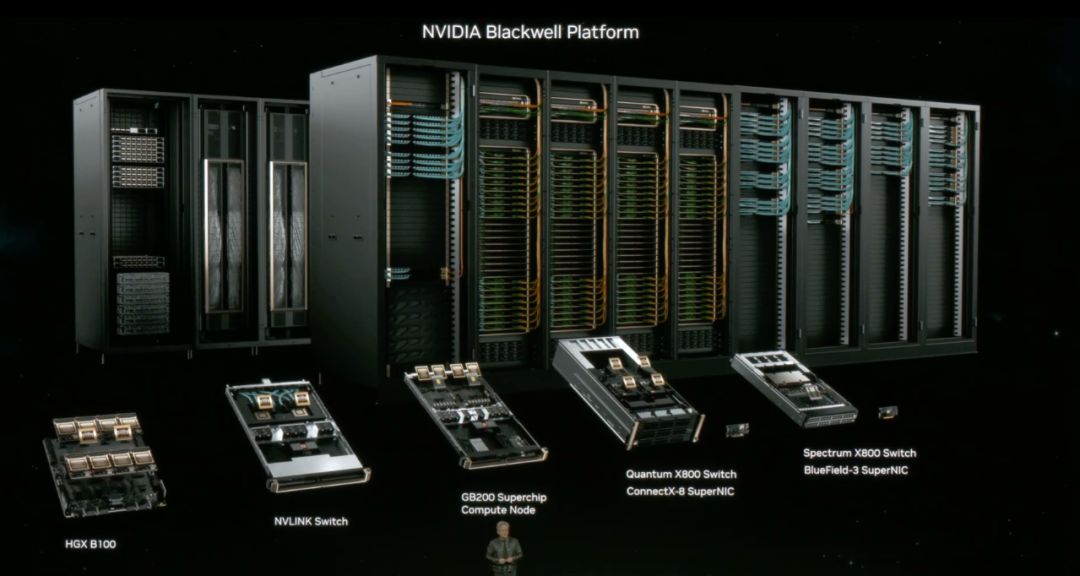

把18个tray连在一个机柜,背后用NVLink链接,就是36个GB200,72个GPU,所以叫做“GB200 NVL72”。这是最大的“GPU”。

不只是硬件,英伟达也在软件上火力全开,软件是英伟达的另一个杀手锏,构成了它的护城河。

在今天的发布会上,英伟达推出了集成过去几年所做的所有软件于一起的新的容器型微服务:NVIDIA NIM,构建于NVIDIA CUDA平台之上 ,可对来自英伟达及其合作伙伴生态系统的20多个主流的AI模型进行优化推理,使得部署AI变得更容易,这就更加增加了客户使用英伟达芯片的粘性。

正如老黄在最后一张PPT做的总结,新的Blackwell系统:新的GPU,新的NVLink,新的GB200超级芯片,新的X800交换机,新的Blackwell平台。

针对这些AI时代的弄潮儿,我们可以大致分为4类,分别是:出售人工智能驱动的应用程序的企业;AI模型本身的企业,例如GPT-4,以及帮助企业使用人工智能、专注自然语言处理和人工智能的 Hugging Face;托管AI模型和应用程序的云计算平台,比如亚马逊AWS、微软Azure、谷歌云;以及硬件厂商,比如半导体公司(AMD、英特尔和英伟达等)、服务器(戴尔)和网络设备商(Arista)。

在这四类中最赚钱的,是硬件厂商。根据经济学人的统计,这类主要厂商的总市值已达5万亿美元。这也在情理之中,毕竟首先要构建底层物理基础设施,才能提供软件。

而在这些硬件厂商中,最大的赢家当属英伟达,根据IDC的数据显示,全球 80% 以上的人工智能芯片均由该公司生产。在发布2024财年第四季度财报后,其股价再创新高峰,一路飙升至近800美元,总市值近2万美元,成为美股的第三大上市公司,超越谷歌和亚马逊。而CEO黄仁勋的个人财富也水涨船高,总资产近700亿美元,跻身全球富豪榜前二十。

然后是云层。自人工智能热潮开始以来,谷歌母公司Alphabet、亚马逊和微软的总市值跃升了 2.5 万亿美元,预计到 2024 年,生成式AI将为云巨头的销售额带来200亿美元的收入。从长远来看,云巨头或将是这场AI变革中最大的赢家。

因此,我们也看到,芯片厂商英伟达已经开始向云计算市场一步一步试探,先后投资了CoreWeave、Lambda Labs两家美国的中小云服务商,并且向其倾斜分配稀缺的GPU芯片。

英伟达对“亲信”CoreWeave可谓非常偏心。在一份研究机构Omdia披露出的英伟达H100供货单中,CoreWeave获得的H100数量,比特斯拉还多。要知道,在过去一年,英伟达GPU极度短缺,全世界的大厂或创业公司都在各显神通解决“GPU荒”难题。

从破产边缘到80亿美元估值

CoreWeave最开始是一家“挖”比特币的公司,它的三位创始人最初也只是想通过“挖矿”来赚取额外收入,那时候他们的本职工作是经营对冲基金和家族办公室。

“挖矿”需要GPU,在生成式AI火爆之前,这也是英伟达GPU在作为游戏显卡之外,最赚钱、最大的应用场景。CoreWeave也购买了英伟达GPU,其首席执行官回忆道,“2016年,我们购买了我们的第一块GPU,插上电源,将其放在了俯瞰东河的曼哈顿下城办公室的台球桌上,然后挖掘了以太坊网络上的第一个区块。”

伴随加密货币热,CoreWeave的GPU越买越多,在 2018 年底,CoreWeave成为北美最大的以太坊矿工之一——手握超过五万块GPU,占以太坊网络的1%以上。

在2018年之后,市场行情急转直下,加密货币大幅贬值,与加密货币深度绑定的CoreWeave也元气大伤,几度面临财务危机,险些倒闭。为此,他们决定转型,2019年CoreWeave开拓了新业务,围绕英伟达的芯片构建了专门的云基础设施,将GPU云提供给其他企业开发人员,相当于算力经销商。

这个转型,不曾想成为命运齿轮转动的节点。到2022年底,ChatGPT发布,生成式AI突然爆火,CoreWeave手头数万块GPU成为了硬通货,它摇身一变,依靠手中积攒的GPU,向OpenAI、微软、Inflection等众多AI巨头卖算力。

更重要的是,他们被英伟达看上了。2023年4月,CoreWeave还获得来自英伟达的B轮融资,成为了英伟达的“直系云算力供应商”。

英伟达对于CoreWeave的偏爱已经到达了“视如己出”的程度。CoreWeave作为一家成立4年的初创公司,从英伟达那里拿到GPU超过了特斯拉这样的巨头,几乎和亚马逊这种云计算行业的霸主获得了同样的待遇。甚至连微软都要向CoreWeave订购云算力。CoreWeave这场始于挖矿的奇幻漂流,如今走向了炙手可热的舞台C位。

同样被英伟达看上的还有 Together AI 。近日,由英伟达支持的生成式人工智能初创公司Together AI宣布,在最新一轮的融资中成功筹集了1.06亿美元,公司估值达到13亿美元,而在去年11月估值仅为5亿美元,短短几个月便翻了一倍多。

英伟达的投资领域涉及AI产业链的各个环节,雄心勃勃的芯片巨头英伟达,正构建起自己的“AI帝国”,所涉及的领域之广,绝非昔日能比。而它面临的竞争对手,也是不断增长,且都不是等闲之辈。

正如AMD首席执行官苏姿丰预测,人工智能芯片销售收入将从 2023年的450亿美元增加到2027年的4000亿美元,这对于英伟达来说是难以消化的。

英伟达的竞争对手都希望从泼天的富贵中分一杯羹。AMD和英特尔等老牌企业步步紧逼,都在积极推进AI芯片的开发。英伟达最大的客户——三大云巨头谷歌、亚马逊、微软,也都在推出自研算力芯片,以此来降低成本,也降低对英伟达的技术依赖。

还有制造超高速人工智能芯片的 Groq 和制造超大芯片的 Cerebras 等初创公司也是如此。

Groq成立于2016年,团队脱胎于谷歌 TPU,其爆火主要是因为处理速度非常快。据媒体报道,该公司的芯片推理速度较英伟达GPU提高10倍,成本只有其1/10。运行的大模型生成速度接近每秒500 tokens,碾压ChatGPT-3.5大约40 tokens/秒的速度。

Cerebras 同样成立于2016年,是一家美国AI芯片独角兽公司。就在近日,Cerebras重磅发布了“第三代晶圆级引擎”(WSE-3)。性能上,WSE-3是上一代WSE-2的两倍,且功耗依旧保持不变。90万个AI核心,44GB的片上SRAM存储,让WSE-3的峰值性能达到了125 FP16 PetaFLOPS。这相当于52块英伟达H100 GPU!不仅如此,相比于800亿个晶体管,芯片面积为814平方毫米的英伟达H100。

没人愿意错过AI这场科技盛宴,大家前赴后继踏上这场漫长征途。

不过,未来几年英伟达对GPU市场的控制似乎依然稳固。诞生于2006年的CUDA被认为是英伟达在GPU上建立霸权的关键功臣——它使得GPU从调用 GPU计算和GPU硬件加速第一次成为可能,让 GPU 拥有了解决复杂计算问题的能力。没有业绩记录的初创公司,将很难说服大客户为其新技术重新配置企业硬件系统,云巨头对自有芯片的部署也仍然有限。

现在,有了世界最强的处理器Blackwell,新一轮技术革命即将开启,想要挑战英伟达 GPU 的霸主地位更非易事。

本文内容仅供交流学习之用,不构成任何投资建议,如有疑问,敬请与我们联系info@gsi24.com。